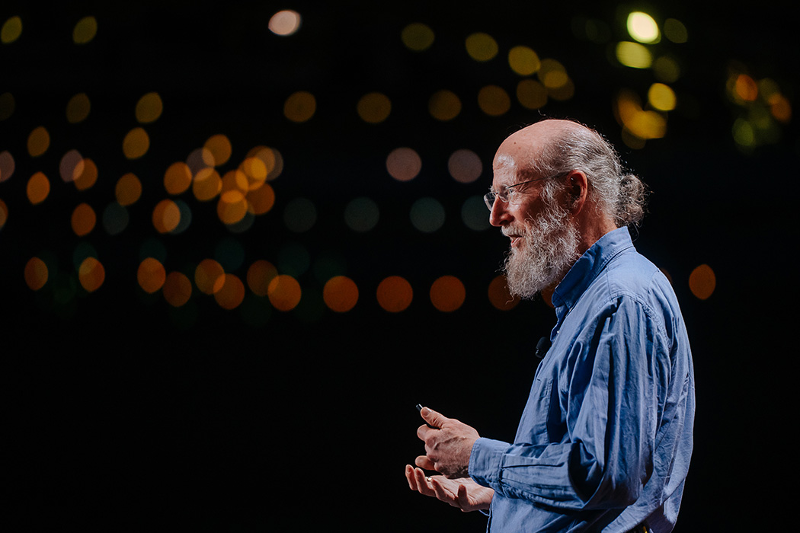

Richard Sutton – Father of RL thinks LLMs are a dead end

- 🤖 AI的不同视角

- 强化学习(RL)与大语言模型(LLM)不同,RL侧重理解世界,而LLM注重模仿人类行为。

- RL的目标是通过经验学习,而LLM是通过模仿和训练数据学习。

- 🧠 世界模型的争议

- 许多人认为LLM有“世界模型”,但Sutton认为它们只是模仿人的模型,并不真正预测世界的变化。

- RL通过奖励机制帮助系统学习“正确”的行为,LLM没有反馈来判断“正确”与否。

- 🎯 目标与智能

- Sutton认为智能的本质是设定目标并通过行动实现目标,而LLM的“目标”只是预测下一个词,不具备对世界的影响力。

- 强化学习中,通过反馈不断调整目标并获得奖励,这是智能的基础。

- ⚙️ 经验学习 vs. 模仿学习

- RL侧重于从经验中学习,不断调整行为以获得奖励,而LLM则依赖模仿学习,没有这种反馈机制。

- 虽然人类初期也通过模仿学习,但成长过程中通过经验和试错逐渐学会适应世界。

- 🧳 长远目标与奖励

- 在RL中,长远目标(如下棋或创业成功)通过短期奖励(如吃掉棋子或每一个商业进步)来维持。

- 人类通过长期目标与短期奖励相结合,在生活中积累经验,而这正是AI需要实现的能力。

- 🌍 大世界假设

- Sutton强调,世界过于复杂,无法在一开始就通过训练数据完全教会AI所有的知识。AI必须在“实践中”不断学习和适应。

- RL的学习来自世界的互动,而LLM则被限制于预定的训练数据和上下文,缺乏持续的在线学习能力。

- 🔄 学习的本质

- Sutton认为,学习不是单纯的“训练”,而是一个持续的过程,强调从实际体验中积累知识。

- 🧠 学习过程和模型

- 强调 学习策略 (policy)、**价值函数** (value function) 和 世界转变模型 (transition model)

- 世界模型:学到你行为的后果 🌍

- 感知组件:感知当前状态 🧭

- 奖励的作用:奖励是学习的一部分,但不是唯一的驱动力 🎯

- 🎮 MuZero 和 AGI

- MuZero 为专用游戏设计框架,需要专门训练,不具备跨任务通用性 🕹️

- AGI 的发展面临 信息约束 和 迁移学习 的挑战 🔄

- 💡 强化学习的迁移和泛化

- 强化学习中 迁移 和 泛化 仍然是 未解决的难题 🧩

- 人类干预 在深度学习模型中起到关键作用 🔧

- 需要 更好的算法 以确保 迁移学习 正常工作 🚀

- 🤖 大规模语言模型 (LLM)

- LLM 的 泛化能力 仍然有限,不完全属于 泛化 的范畴 🤔

- 编码代理 变得越来越擅长多种任务,但还不完全具备超强泛化能力 🌐

- 🌍 未来的AI研究方向

- AGI 的继承问题:AGI 的发展必然带来对人类角色的转变 ⚡

- 人类的未来可能被 智能化设计 所主导,而不是 复制 🛠️

- 🌱 人类与AI的关系

- 人类的责任:理解AI发展的多种可能性,既包括正面也包括潜在的负面影响 💡

- 视角转变:**设计智能** 代表人类走向更高的文明阶段 🌌

- AI继承:AI的进化可能导致 人类未来的变革 🌍

- 🔮 未来的挑战

- 科技进步的速度可能导致人类 失去控制,需谨慎对待未来的变革 ⚠️

- 强调对 全球未来 的辩论和多样性看法,要避免 单一控制 🗣️

- 🤖 AI & Values: 提议AI应具备高诚信和道德价值观,即使不完全一致,也能像教育孩子一样,教导AI不从事有害行为,保持诚实与拒绝恶意行为。

- 🧑👧 教育与价值观: 虽然我们无法完全达成普遍的价值观共识,但可以教导孩子高尚品质,AI也可通过类似的方式培养。

- 🌍 社会设计与变革: 强调社会变革应是自愿的,而不是强制的,这是人类社会设计的核心任务之一。

- ⏳ 社会与AI的演变: 人类社会的价值观不断演变,AI也应考虑未来的演变方式,保持一定的灵活性和适应性。

- 🧠 AI的技术基础: 讨论AI发展的技术从早期便已存在,并在深度学习中得到应用,展现出技术与社会的深层联系。

- 🤝 总结: 整个讨论聚焦于AI、价值观及其在未来社会中的应用,强调人类与AI共生发展的重要性。

- 感谢你赐予我前进的力量